La revolución de la Inteligencia Artificial enfrenta su gran cuello de botella: la energía

“¿Y qué rol juega Argentina acá?”, se preguntó la directiva ante clientes, proveedores y la prensa. “Creo que ustedes lo están viendo: Argentina tiene energías renovables, lo cual es muy bueno, pero tenemos que seguir aprovechando el régimen de incentivos de atracción de grandes inversiones para Argentina, porque claramente estamos en un momento donde podemos seguir trayendo esa inversión. Sudamérica sigue siendo un potencial en toda la parte de data centers. Lo vemos en países como Brasil, como Chile, incluso Colombia, y eso es lo que tenemos. O sea, Argentina está en ese camino y tenemos que seguir preparándonos”, enfatizó.

En diálago con este medio, Sánchez recordó que la última vez visitó el país en agosto del 2024 la situación era un poco diferente. “Había bastante incertidumbre, hoy en día pienso que estamos en un momento donde las cosas están un poco más estabilizadas. Los canales, los partners están viendo las oportunidades, algunas inversiones que se han estado conteniendo, pero están en un escenario muy positivo para lo que sigue el año, y eso es muy bueno”, estimó.

Según proyecciones optimistas, el sector de centros de datos en Argentina podría movilizar inversiones por hasta 11,75 millones de dólares para 2027, impulsadas por tendencias no sólo de inteligencia artificial sino también de la digitalización.

Noelia Miranda, directora de Secure Power para APU, también observa un escenario muy optimista. “Cuando hablamos con nuestros socios de negocios, tanto en la parte de canales de valor como los distribuidores, mismo en las alianzas con las trabajamos, todos tienen un escenario optimista. Las inversiones están repuntando, por ahí sí se alargan un poco más los plazos las tomas de decisiones finales, pero es un escenario súper optimista”, recalcó.

Y sobre medidas económicas recientes como levantar el cepo y retirar dividendos, Miranda aseguró que si bien son tomadas positivamente, “no provocaron ningún tipo de cambio de dinámica de negocio” con respecto al tipo de cambio, o la fluctuación del dólar. “Hemos mantenido el negocio lo más estable posible, más allá de estos cambios”, afirmó.

Al ser consultada sobre la posiblidad de instalar un megadata center para IA en el país, Miranda aclaró: “En Argentina por el momento no tenemos visibilidad de un gran datacenter de inteligencia artificial y esa es la realidad. Sí se ve la tendencia de nuevos jugadores que consultan, que preguntan, que hoy tienen un procesamiento de datos dentro de un host, lo que nosotros llamamos un co-location, y que ya están preguntando para armar su propio datacenter en la región, en el país. Es decir, migrar de un modelo de co-location a un datacenter propio. Eso se escucha muchísimo. Todavía no tenemos visibilidad, obviamente no hay nada concreto, pero las conversaciones están dando, y se escucha muchísimo”.

Cuánta energía se necesitará para la IA en 2030

Hernán Neirotti, del área de Energy Management Business de Schneider, fue uno de los oradores de la firma en Cardales. Y sin dudas su foco fue en la eficiencia de equipos. “Estamos hablando de una transformación radical en la infraestructura tecnológica. Los centros de datos actuales no fueron diseñados para soportar densidades energéticas tan elevadas ni las exigencias térmicas de los clústeres de GPU que requiere la IA”, explicó

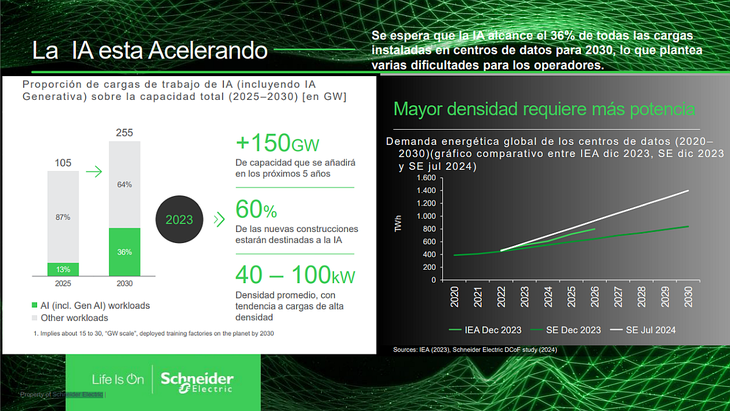

Según estudios privados a los que accedió Energy Report, la demanda energética de los data centers crecerá más de 150 GW (gigavatios) en los próximos cinco años.

Un consumo de 150 GW es una cantidad extremadamente grande de energía eléctrica, y es comparable con el consumo anual de electricidad de un país grande o de una región entera.

Para ponerlo en perspectiva, algunos países consumen alrededor de 250,000 – 300,000 GWh al año, lo que equivale a aproximadamente 28,5 – 34,2 GW de consumo promedio continuo.

Los desafíos de los data centers en un mundo digitalizado

Según Schneirder, los data centers procesan y almacenan información de miles de millones de dispositivos conectados en todo el mundo. Sin embargo, este rol conlleva desafíos importantes. Para 2027, se estima que el consumo eléctrico de data centers sea el 2,5% de la demanda mundial. En los últimos años, la creciente adopción de IA impulsa un incremento del 48% en las emisiones de carbono de gigantes tecnológicos como Google.

Además, en los últimos cinco años, la densidad de los racks de servidores ha pasado de 2-3 kW a 20-60 kW, generando un incremento proporcional en el calor producido. “Un rack de 20 kW puede emitir hasta 67 veces más calor que uno de 3 kW, aumentando los costos y el riesgo de fallos operativos”, explica Gabriel Estay, director de Data Center y Secure Power para el Clúster Andino en Schneider Electric.

Por otro lado, el 40% de la energía utilizada por un centro de datos se destina a su sistema de refrigeración. Métodos tradicionales como el enfriamiento por aire demandan grandes volúmenes de agua y electricidad, impactando en los recursos naturales y elevando costos operativos. Asimismo, frente a un contexto de cambio climático, reducir las emisiones es una prioridad. Un data center de 10 MW puede emitir hasta 50.000 toneladas de CO al año, lo que equivale a las emisiones de 10.000 autos.

De la nube al chip: una infraestructura que se reinventa

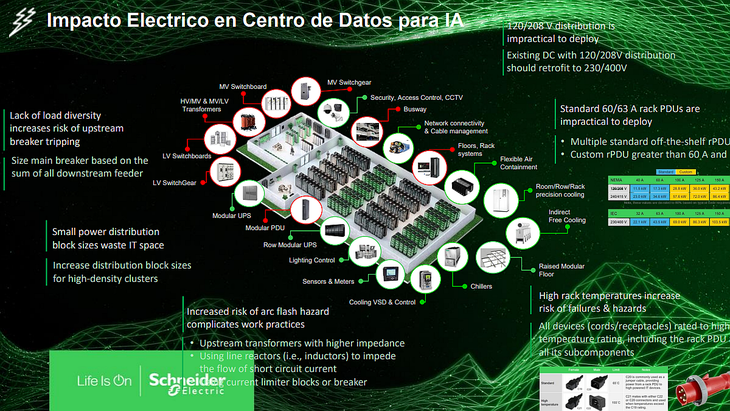

Los nuevos data centers de IA están llamados a operar con densidades de entre 40 y 100 kW por rack, lo que multiplica el consumo energético por servidor y obliga a repensar desde la arquitectura eléctrica hasta los sistemas de refrigeración.

Los sistemas tradicionales de 120/208V están quedando obsoletos. La recomendación ahora es migrar a configuraciones de 230/400V, implementar tableros de baja tensión modulares y usar transformadores secos con alta eficiencia térmica. Todo el “powertrain” debe ser rediseñado para manejar cargas críticas, no lineales y de alta variabilidad.

“El diseño eléctrico tiene que asumir que todas las cargas de IA pueden operar simultáneamente. No hay espacio para subdimensionar o improvisar”, advierte Neirotti. Esto implica interruptores más robustos, PDUs de mayor capacidad por toma y sistemas de protección contra fallos y arcos eléctricos.

El enfriamiento líquido: de lujo a necesidad

Otro factor clave es el enfriamiento. La IA requiere servidores densos que generan calor extremo. Schneider Electric propone una arquitectura modular de enfriamiento líquido que incluye Cooling Distribution Units (CDUs), chillers de alta temperatura y refrigeración directa en rack o fila.

“El 95% del calor se disipa por refrigeración líquida en los racks de IA de última generación”, señaló Neirotti. “Esto obliga a integrar el sistema de cooling desde el diseño inicial. Ya no se trata de un accesorio, sino de una pieza central para garantizar la operatividad”.

La expansión de estas unidades también trae desafíos energéticos y ambientales. Así lo indica la Agencia Internacional de Energía (AIE), al señalar que, si no se toman medidas para mejorar la eficiencia energética de los data centers, el consumo eléctrico global de los mismos podría duplicarse para 2030, alcanzando aproximadamente 945 teravatios-hora (TWh) anuales, impulsado por el aumento de la inteligencia artificial y la digitalización.

En este escenario, la refrigeración líquida (Liquid Cooling) emerge como una tecnología clave para hacer frente a estos retos. Luis Santamaría, líder del segmento de Cloud & Service Providers de Schneider Electric, explica que “esta tecnología se presenta como una alternativa superior a los sistemas tradicionales de aire, permitiendo una transferencia de calor más eficiente y una mejor gestión térmica para equipos de alta densidad”. Esto es particularmente relevante para soportar cargas de trabajo intensivas, como inteligencia artificial (IA) y cómputo de alto rendimiento (HPC), que demandan una mayor capacidad de procesamiento y generan niveles de calor significativamente superiores.

En este sentido, el Liquid Cooling está revolucionando la industria de los centros de datos al mejorar la eficiencia energética y reducir el uso de agua. Su aplicación no solo beneficia a los grandes data centers, sino también a implementaciones en el borde de la red, permitiendo operar en entornos con limitaciones de espacio o condiciones adversas. Además, este enfoque innovador está impulsando la adopción de la refrigeración líquida en la industria de TI a nivel global.

Es así como el mercado de refrigeración líquida está en plena expansión. De hecho, según Douglas Insights, el mercado del enfriamiento líquido crecerá a un ritmo anual del 20% hasta 2028. De manera similar, un análisis del mercado de refrigeración líquida para data centers, realizado por Mordor Intelligence, proyecta que alcance los 11.800 millones de dólares en 2028.

“La transición hacia tecnologías más eficientes y sostenibles es un paso clave para garantizar el crecimiento responsable de la industria digital. En Schneider Electric estamos comprometidos en liderar este cambio con soluciones innovadoras que permiten optimizar el consumo energético y reducir la huella de carbono de los centros de datos”, concluye Santamaría.

Hacia un ecosistema energéticamente inteligente

La respuesta de la industria no puede limitarse a agregar más potencia. El futuro de la IA depende también de cómo se optimiza el uso de la energía, minimizando pérdidas y maximizando eficiencia. Por eso aparecen opciones con sistemas de monitoreo inteligente, UPS escalables, blindobarras flexibles y plataformas digitales como EcoStruxure.

Una muestra concreta de esta visión se plasmó en la colaboración entre Schneider Electric y NVIDIA, que desarrollaron un diseño de referencia para clústeres de IA basados en GPU GB200 NVL72. Estos racks, que alcanzan los 120 kW por unidad, representan el punto más avanzado en la convergencia entre potencia, enfriamiento y control digital.

Cómo tener data centers más eficientes

Gabriel Estay recomienda a las empresas implementar estrategias para reducir el consumo energético y hacer más sostenibles sus data centers. El experto señala cinco acciones clave y algunos ejemplos en esta ruta:

Refrigeración líquida: Reduce el consumo energético hasta en un 40% en comparación con el enfriamiento por aire. Un ejemplo es el Proyecto Natick de Microsoft, que probó centros de datos submarinos para mejorar la disipación del calor.

Free cooling: Utiliza el aire exterior en climas fríos para enfriar servidores sin necesidad de aire acondicionado. Facebook implementó esta técnica en sus centros de datos en Suecia.

Reutilización de calor residual: En Finlandia, el calor generado por los servidores se redirige a sistemas de calefacción urbana, reduciendo la dependencia de combustibles fósiles.

Energías renovables: Google y Amazon han invertido en energía solar y eólica para alimentar sus centros de datos, reduciendo su impacto ambiental y costos operativos.

Optimización con IA: Herramientas como EcoStruxure Resource Advisor de Schneider Electric permiten monitorear y gestionar en tiempo real el consumo energético de los data centers, mejorando su eficiencia operativa.

Finalmente, Estay agregó que el uso de sistemas de alimentación ininterrumpida (UPS) eficientes también cumplen un rol clave en la reducción del consumo energético. Tecnologías como la UPS Galaxy VXL alcanzan una eficiencia del 99%, minimizando las pérdidas de energía y reduciendo la huella de carbono.

Un nuevo paradigma energético global

Según los estudios de la compañía, la demanda energética de los data centers crecerá más de 150 GW en los próximos cinco años. Más del 60% de las nuevas construcciones estarán destinadas exclusivamente a soportar cargas de IA.

El reto ya no es tecnológico, sino estructural. ¿Dónde se generará esa energía? ¿Cómo se distribuirá? ¿Es posible sostener este crecimiento sin comprometer los objetivos climáticos?

Neirotti es claro: “El futuro de la IA no es sólo computacional, es energético. Necesitamos políticas que acompañen esta evolución con infraestructura robusta, regulación flexible e incentivos para el uso eficiente y sustentable de la energía”.

En definitiva, la carrera por la inteligencia artificial no se juega sólo en los laboratorios de software, sino en las redes eléctricas, las subestaciones, los transformadores y los sistemas de refrigeración de alta precisión. Allí donde la innovación digital se encuentra con los límites físicos del planeta.

Como dijo Marta Sánchez: “La IA ha llegado para quedarse, ha llegado a potenciar al ser humano. Hay disciplinas y roles que seguramente van a transicionar, porque algo que trae la inteligencia artificial es sobre todo simplificación y eficiencia en muchas cosas operativas, pero es cuando nosotros como seres humanos podemos transicionar también a generar más valores las cosas que hacemos y va a llevar también a un desarrollo de nuevas profesiones y demás, pero para mí indiscutiblemente es un potenciador para el ser humano, para la humanidad”.