Esta IA capaz de predecir decisiones humanas abre el debate sobre si puede pensar o no

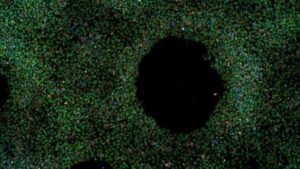

¿Qué pasa si tomas un modelo de lenguaje extenso avanzado como LLaMA de Meta y lo entrenas con una base de datos de experimentos psicológicos, que incluyen 10 millones de decisiones tomadas por 60,000 personas? Obtienes una inteligencia artificial (IA) capaz de simular el proceso cognitivo de un ser humano y predecir sus decisiones. Eso es, al menos, lo que sostiene un innovador y polémico estudio publicado en Nature.

La IA se llama Centaur porque combina un modelo LLaMA (nombre inspirado en el cuadrúpedo andino) con capacidades humanas cognitivas. Su objetivo es emular lo que una persona haría bajo cualquier experimento expresable en un lenguaje natural y obtener datos preliminares antes de que los científicos recurran a participantes reales. Una herramienta así sería de suma importancia con pruebas que incluyan a menores de edad o personas con afecciones psiquiátricas.

Los investigadores están entusiasmados porque las representaciones internas del modelo fueron similares a los patrones de actividad neuronal de una persona. Ello sugiere que la IA toma decisiones siguiendo patrones de procesamiento similares a los del cerebro humano y, por tanto, sus resultados son “más humanos” que otros modelos entrenados solo para imitar una toma de decisión.

Para verificar la eficacia de su modelo, separaron el 10% de las decisiones del conjunto de datos humanos con los que Centaur entrenó. Luego, ya digeridos los 160 estudios psicológicos de distinto enfoque con 60,000 participantes, la IA llegó al resultado de la información retenida de manera más orgánica que otras IAs. También produjo elecciones comparables a humanos en estudios que no estaban en sus datos de entrenamiento.

“Básicamente, se pueden ejecutar sesiones experimentales in silico (en un chip) en lugar de ejecutarlas con participantes humanos reales”, resumió Marcel Binz, coautor de estudio y científico cognitivo del Instituto Helmholtz para la IA Centrada en el Ser Humano, en Múnich, Alemania.

Ante una afirmación radical, escepticismo, pide la ciencia

Sugerir que una IA “piensa” como un humano tras un entrenamiento es atrevido, incluso para quienes desarrollan sistemas de última generación. Después de todo, se trata de uno de los principales objetivos de esa ciencia.

Los resultados de Binz y su equipo mantienen a otros investigadores escépticos, sobre todo a los neurocientíficos. Entre las principales críticas al respecto se encuentra la sobreestimación de su base de datos psicológica. Es muy grande, cierto, pero resulta en extremo diminuta para la dimensión en la complejidad del cerebro humano y los procesos neuronales que llevan a una persona a tomar una decisión.

Quienes han podido hacer pruebas con Centaur afirman que la manera en que llega a esos resultados es, paradójicamente, “antihumana”. Puede que emule las respuestas de una persona, pero el mecanismo para llegar a ella no tiene nada que ver con la mente. La revista Science recoge el testimonio del científico cognitivo Jeffrey Bowers, de la Universidad de Bristol. Según su experiencia, Centaur tiene la capacidad de recordar 256 dígitos, mientras que una persona común, como mucho, retiene siete. Sus tiempos de reacción son mayores y sobrehumanos, por lo que no se puede confiar en esta simulación.

Bowers explica la inquietante característica de Centaur con la metáfora de un reloj. Tanto uno digital como uno mecánico pueden medir el tiempo de igual forma, pero dentro de ellos hay lógicas muy distintas. Si se están buscando herramientas para comprender mejor la mente, entonces Centaur no sería la herramienta adecuada.

“Nuestros resultados demuestran que es posible descubrir modelos computacionales que capturen el comportamiento humano en una amplia gama de dominios”, afirman los creadores de Centaur. Mientras tanto, la comunidad científica piensa que, por ahora, decir que una IA “piensa” como persona, es una afirmación injustificada.